分类目录归档:人工智能ai

发表评论

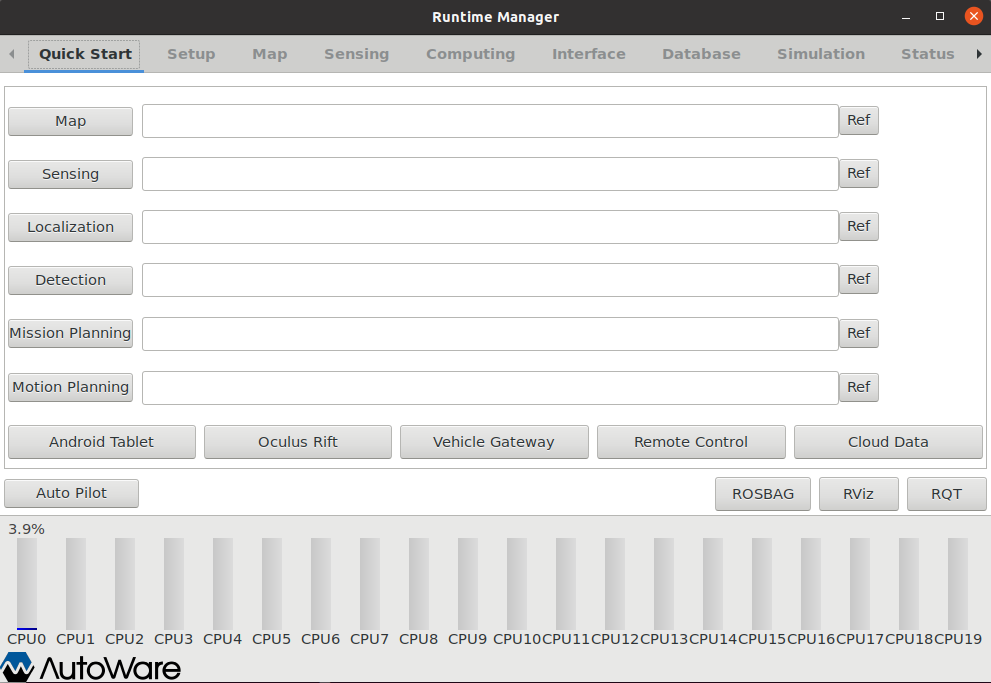

Autoware—GNSS辅助NDT定位

Autoware—定位/导航验证

Unity—MapToolBox绘制VectorMap地图

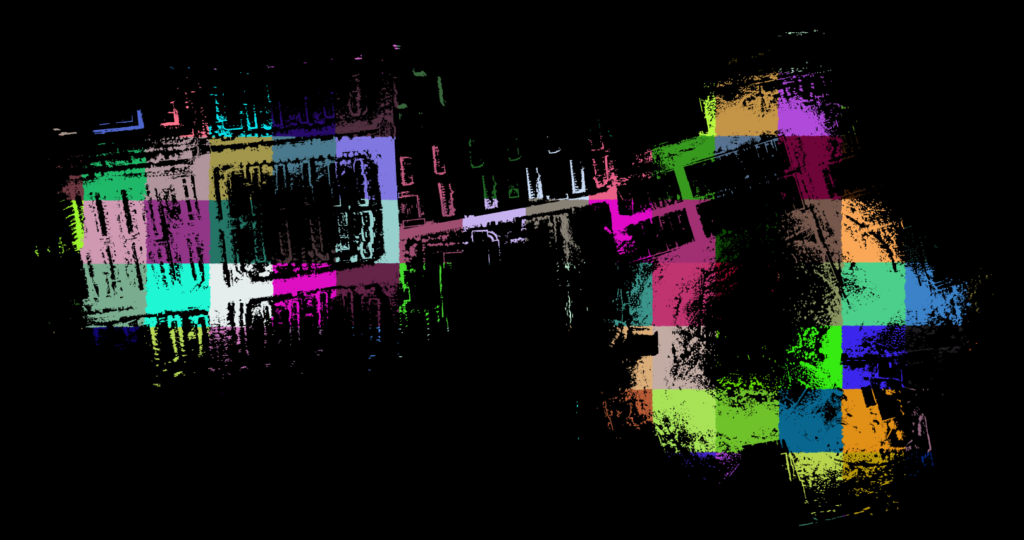

Autoware—3D建图之NDTMapping

Autoware—AI版本的部署

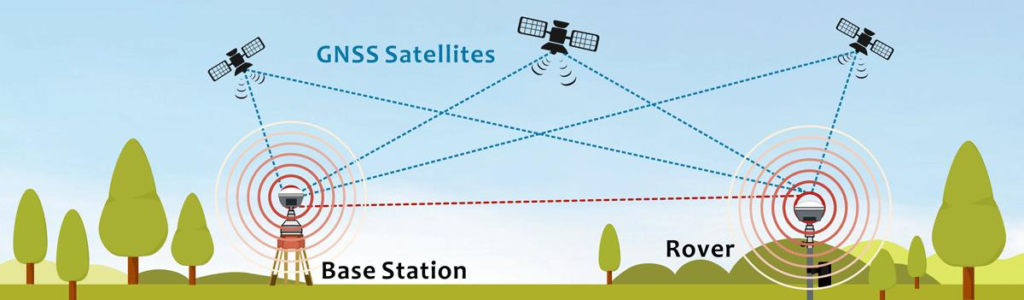

GNSS—G70差分定位RTK模块

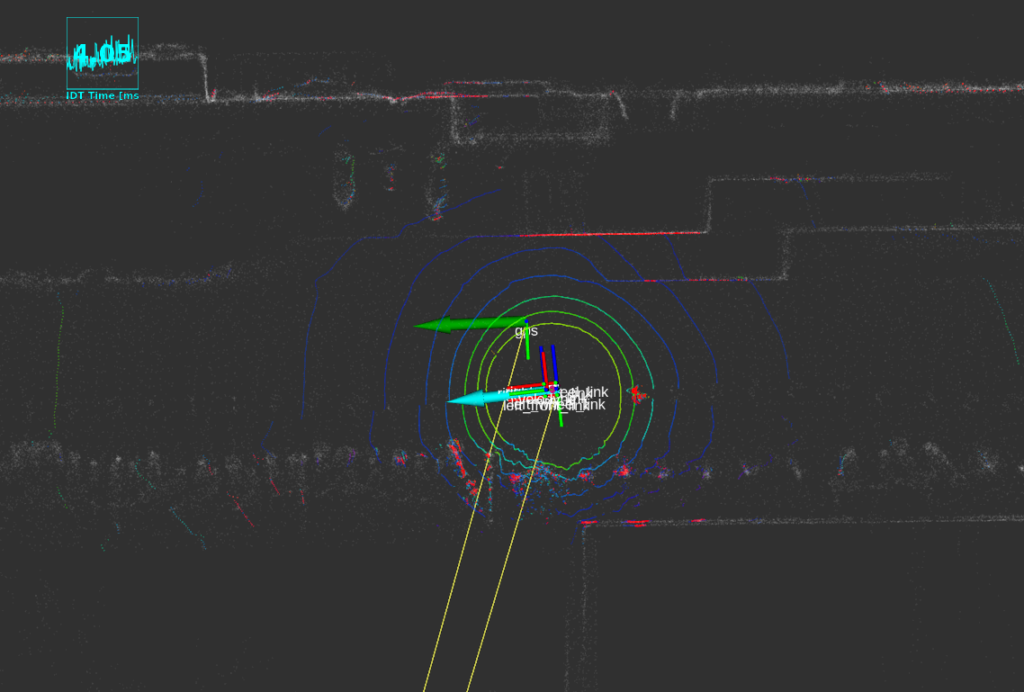

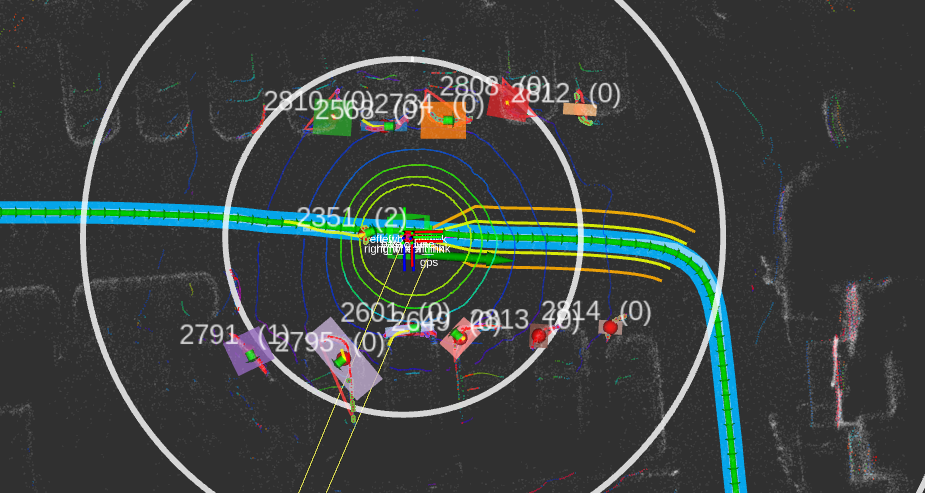

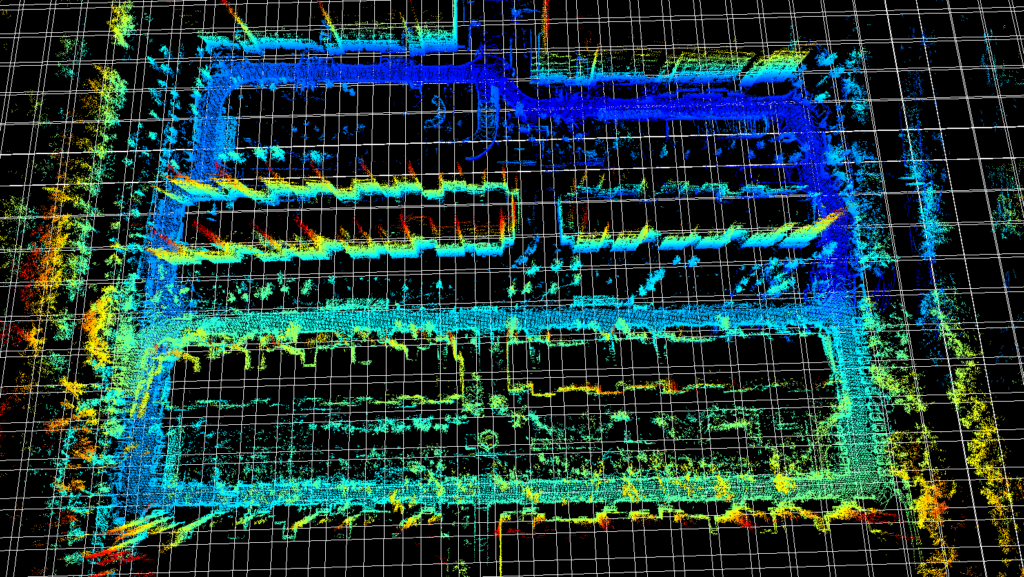

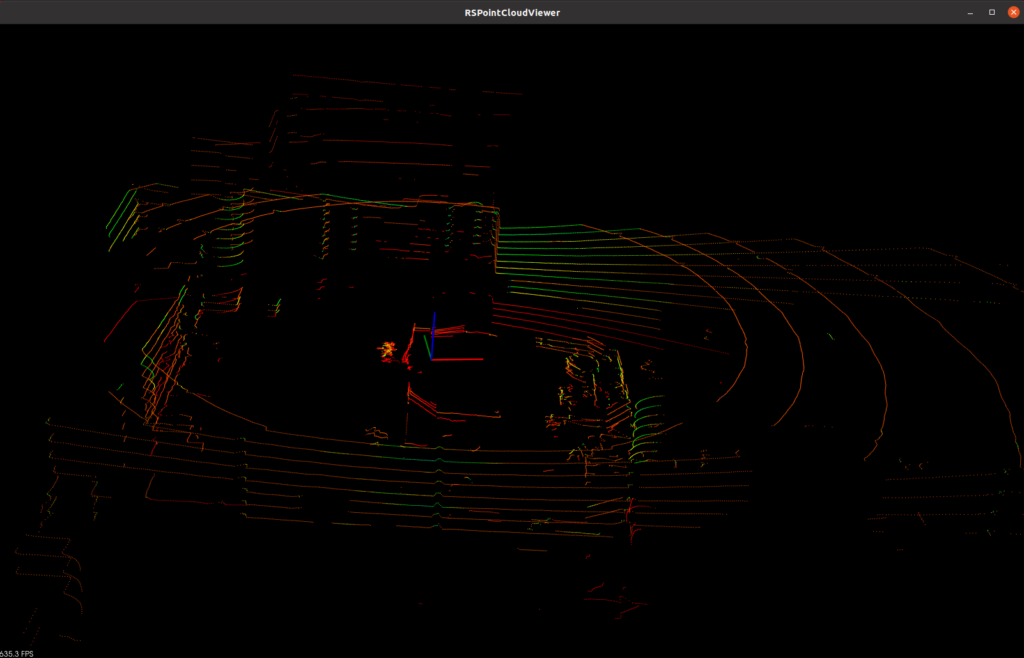

Pandar40P + H30IMU + LIO_SAM建图

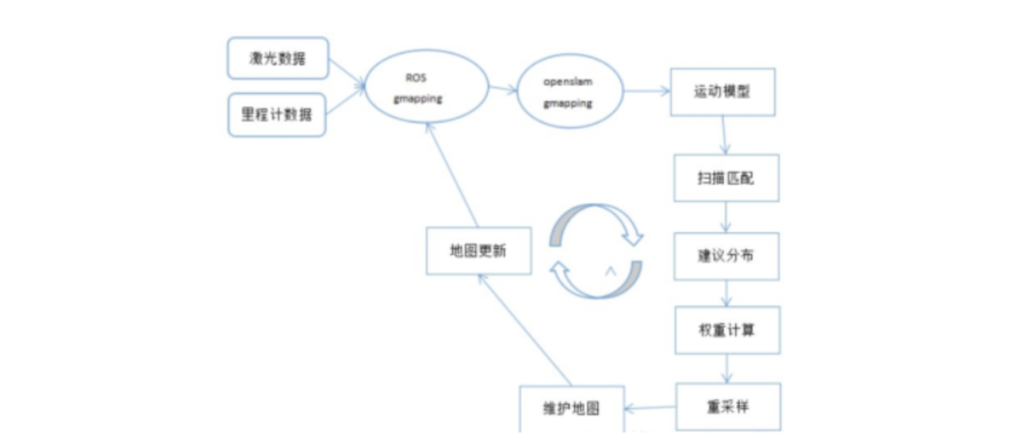

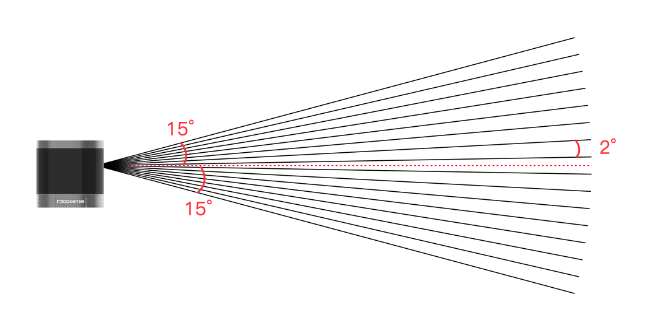

今天开始尝试使用Lidar+IMU进行3D SLAM建图,本文记录下实验过程。

Pandar40P Lidar + H30 IMU 外参标定

IMU—H30九轴AHRS

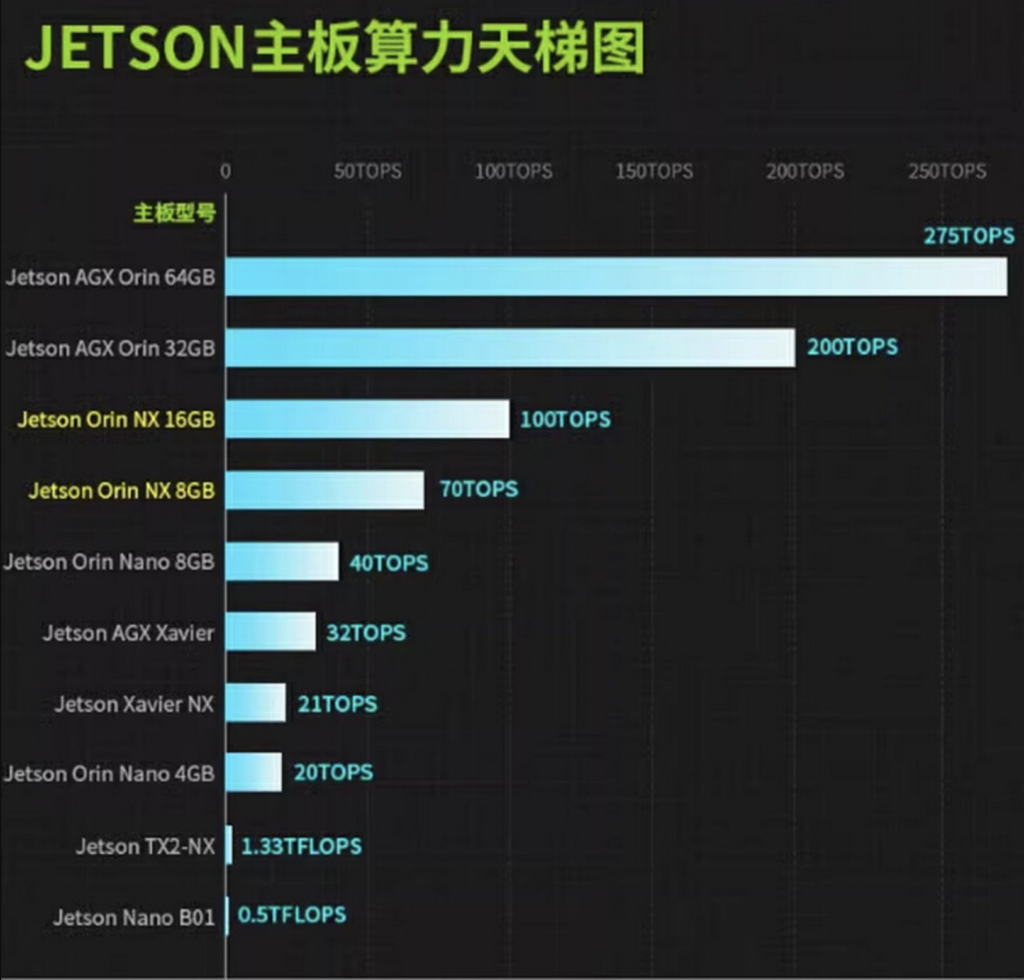

Nvidia Jetson AGX Orin系统刷写

TensorRT 10.x NOTFOUND TENSORRT_NVPARSERS_LIBRARY 问题

问题描述:

在 Ubuntu22.04 + Orin Arm 中构建 tensorrt_common 时,出现未找到 TENSORRT_NVPARSERS_LIBRARY 变量错误。

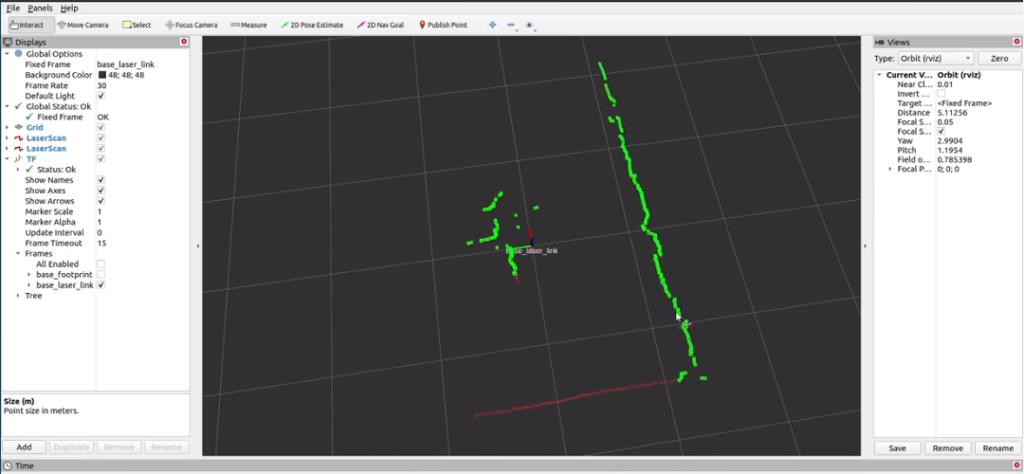

RS16在Ubuntu22下无法显示点云问题

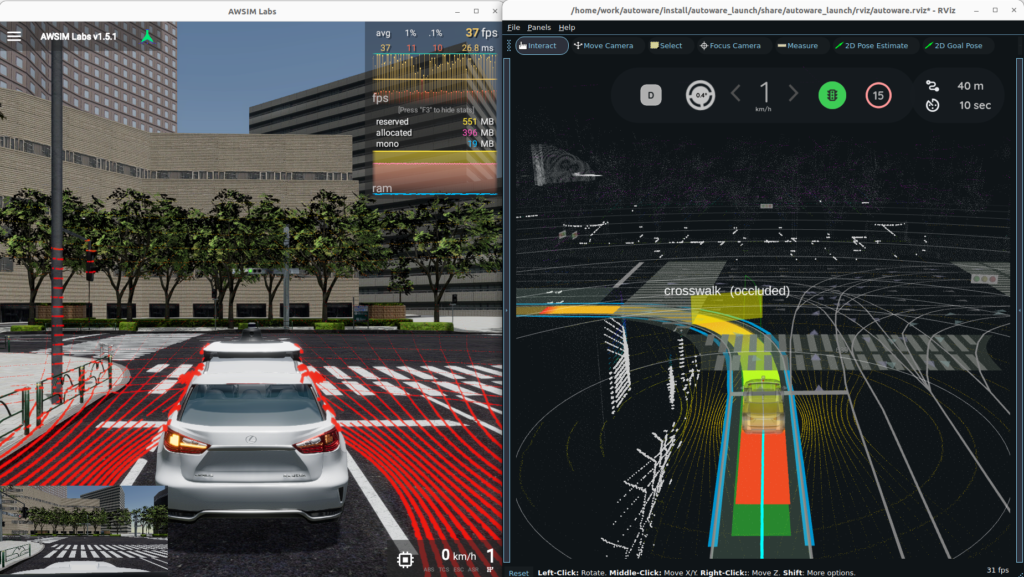

Autoware—Universe初探

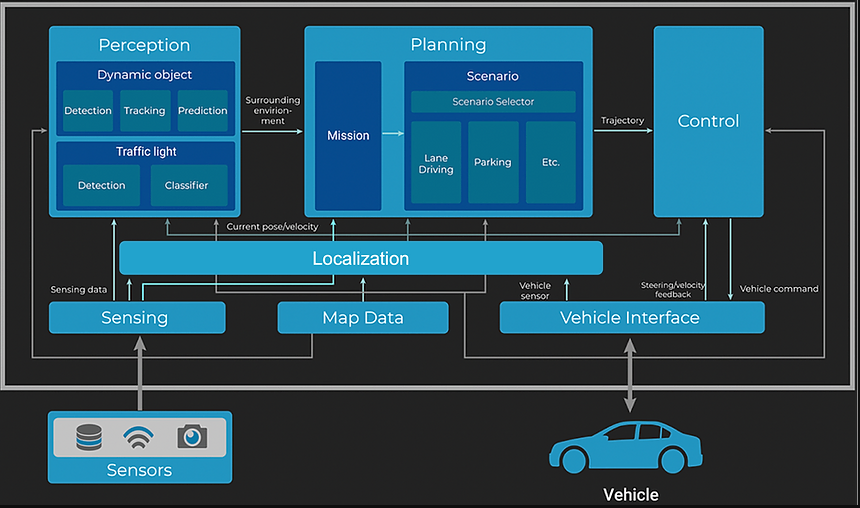

Autoware—概述

自动驾驶线控底盘行业研究报告(2024)

本报告致力于以战略高度洞察行业全貌、消除碎片化认知障碍、明晰市场现状及趋势,推动国内OEM与线控底盘企业紧密协作,早日攻克“底盘系统”这一海外大厂最后掌控的领域,真正掌握汽车智能化转型的主动权。以下为核心内容解读,完整版报告:自动驾驶线控底盘行业研究报告-202408。

一、行业概况

1、什么是线控底盘?目前,行业关于什么是线控底盘并无权威论述,但基本内容比较清楚。本报告参照最新国家标准和电动汽车智能底盘技术路线图,给出如下定义:线控底盘,即以电信号代替机械装置实现对车辆精确控制的底盘系统,核心是人机解耦。

2、机械底盘、线控底盘、滑板底盘与AGV、IGV、AMR